IDTechEx: Heutige Hardware ist noch weit weg von einer überzeugenden Verschmelzung von realer und virtueller Welt

Cambridge, 26. November 2021. Bis uns Meta-Chef Mark Zuckerberg alle in sein Metaversum integrieren kann, das reale und virtuelle Welt verschmilzt, sind noch erhebliche technische Hürden zu überwinden. Das hat das britische Marktforschungs-Unternehmen „IDTechEx“ aus Cambridge eingeschätzt.

Per Smartphone ins Metaversum ist wie Dampflok-Fahren auf der ICE-Strecke

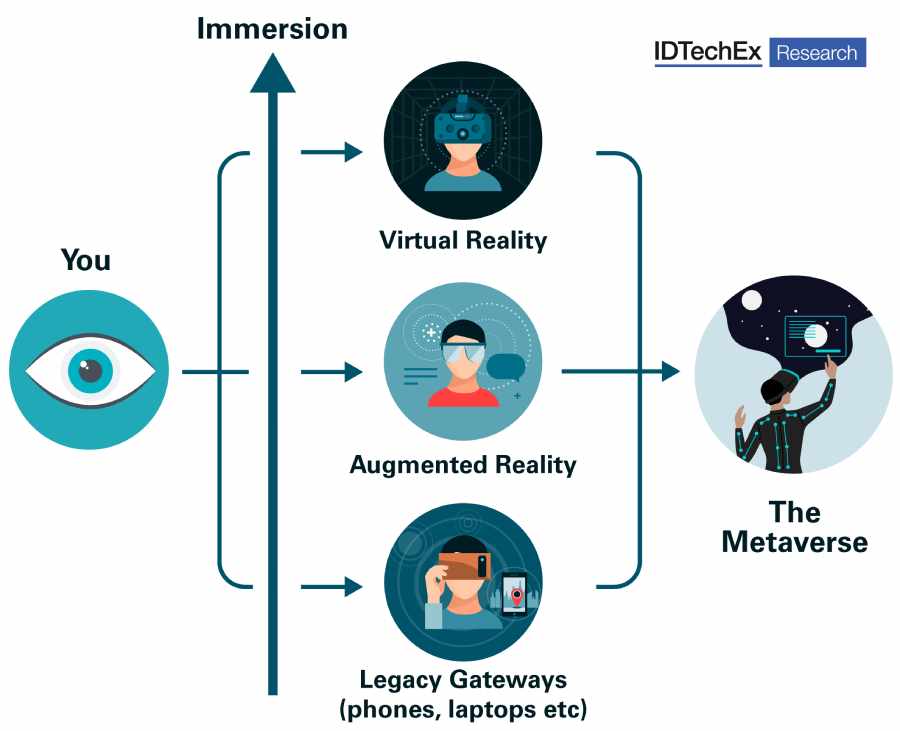

Software-seitig sei es kein grundlegendes Problem mehr, Metaversen zu programmieren, ist IDTechEx-Analyst Sam Dale überzeugt. Dagegen müsse die heutige Hardware noch deutlich verbessert werden, bevor Nutzer wirklich den Eindruck gewinnen, dass reale und virtuelle Welt nahtlos ineinander übergehen. Mit Notebooks und Smartphones könne allenfalls eine Übergangslösung sein: Sie würden in einem Metaversum, wie es sich Zuckerberg & Co. erträumen, stets wie eine qualmende Dampflok auf der Hochgeschwindigkeits-Bahnstrecke eines Shinkansen, TGV oder ICE wirken.

Datenbrillen derzeit noch unausgereift oder zu teuer

Die bisher beste Lösung, um computergenerierte Szenen wie die echte Welt auf den Betrachter wirken zu lassen, sind derzeit Datenbrillen mit Bildschirmen. Doch die sind heute noch viel zu klobig, haben zu kurze Akkulaufzeiten und vor allem zu geringe Bildqualität, um virtuelle und augmentierte Realitäten (VR und AR) wirklich überzeugend darstellen zu können. Und Modelle mit anspruchsvollerer Displaytechnik sind noch sehr teuer. Die Sensorik, Optik, Elektronik, Energieversorgung, die Herstellungskosten und vor allem die Bildschirmtechnik solcher Brillen müssen sich also drastisch verbessern, bis sie in Echtzeit virtuelle Welten in Imax-Qualität ruckelfrei darstellen können. Denkbar sind dabei beispielsweise LED-Mikrodisplays mit Quantenpunkt-Farbkonvertierung oder verbesserte Oled-Mikrodisplays, die langlebiger sind als heutige Modelle und auch keine Einbrenn-Effekte haben.

Bilder per Laserscanner direkt auf die Netzhaut werfen

Neben Datenbrillen gibt es aber inzwischen auch alternative technologische Ansätze. Einige Unternehmen wie etwa Mojo Vision experimentieren beispielsweise mit Nanodisplays, die in Kontaktlinsen hineinpassen, die direkt aufs Auge gelegt werden. Andere verfolgen den Ansatz, mit Laserstrahlen die Bewegtbilder aus der virtuellen Welt direkt auf die Netzhaut des VR-Besuchers zu projizieren. Um dabei die richtigen Teilbilder projizieren zu können, wäre allerdings eine automatische Blickverfolgung („Eye Tracking“) durch das System nötig. Dafür gibt es inzwischen bereits recht raffinierte Lösungen: Meta Materials Inc. – die aber nichts mit dem in „Meta“ umbenannten „Facebook“ zu tun haben – bettet beispielsweise Mikrokameras fürs „Eye Tracking“ direkt in Brillenlinsen ein.

Smartphones und Laptops könnten zwar als Brückentechnologie zu einem Metaversum dienen, würden dort aber wie längst überholte Gerätschaften („Legacy Devices“) wirken. Grafik: IDTechEx

Bessere haptische Handschuhe gefragt

Zudem sind für ein überzeugendes Metaversum neben den Optikproblemen auch haptische Herausforderungen zu lösen. Sprich: Der Besucher will die virtuellen Welten nicht nur in Echtzeit in einer Bildqualität erkunden, wie wir sie bisher nur aus Highend-Kinos kennen, sondern möchte sie auch erfühlen. Dafür müssen unter anderem bessere und billigere haptische Handschuhe entwickelt werden, die dem Träger die Möglichkeit geben, Dinge in der VR-Welt auch zu ertasten.

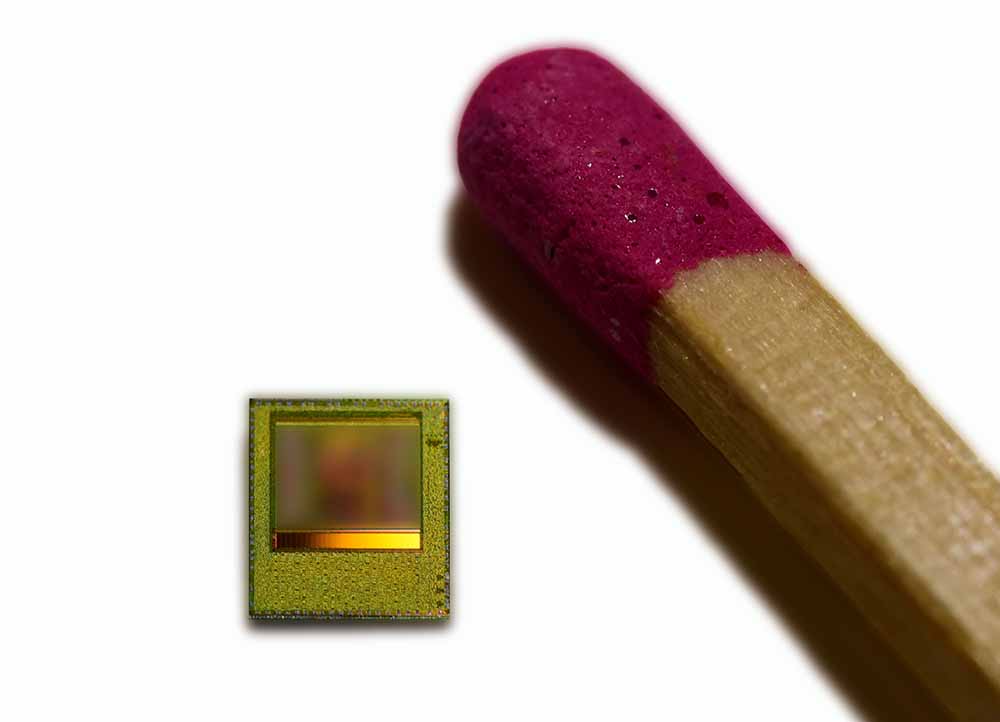

Der 3D-Bildsensorchip „Real 3“ von Infineon im Vergleich zu einem Streichholz. Er berechnet nach dem ToF-Prinzip ein 3D-Bild durch Laufzeit-Unterschiede ausgesandter Lichtteilchen. Foto: Infineon

Neue Perspektiven für Hersteller von ToF-Sensoren

Und eine intuitive Interaktion des eigenen Avatars mit anderen Personen – seien sie nun menschgesteuert oder künstlich – im Metaversum sollte auch nichtverbale Kommunikation ermöglichen. Das heißt: Die Künstliche Intelligenzen, die das Metaversum bevölkern, müssen zuverlässiger als bisher imstande sein, Gesten oder andere Körperbewegungen zu erkennen und zu interpretieren. Einsetzbar wären dafür beispielsweise Sensoren und Kameras mit „Time of Flight“-Technik (ToF), wie sie beispielsweise Infineon Dresden und LG herstellen. Diese Technik macht sich die Endlichkeit der Lichtgeschwindigkeit zunutze. Denn dahinter stecken Systeme, die ein Objektes oder einen ganzen Raum analysieren, indem sie Licht aussenden und aus den winzigen Laufzeit-Differenzen der zurückgeworfenen Strahlen die Geometrie oder – bei wiederholten Messungen – auch die Dynamik einer Szene berechnen.

Metaversum-Technologien stellen letztlich auch Akzeptanzfragen

Für Senorhersteller und andere Elektronikunternehmen bergen Zuckbergs Träume insofern sowohl einige Herausforderungen, aber womöglich auch neue Umsatzschübe. Allerdings sind bei Zusammenspiel all dieser Technologien in einem künftigen Metaversum noch zahlreiche praktische Probleme zu lösen, betonen die IDTechEx-Analysten. Aber vielleicht noch ausschlaggebender aber die Frage, ob diese Technologien auch auf genug Akzeptanz bei den Konsumenten stoßen. Denn womöglich, so kann man überlegen, ist nicht jeder begeistert von der Vorstellung, beispielsweise seine Netzhaut von Laserstrahlen überstreichen zu lassen oder all die Überwachungssensorik im Hintergrund stetig mitlaufen zu lassen.

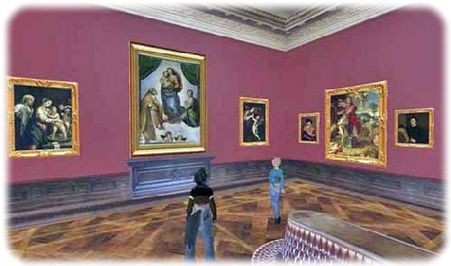

Virtuelle Museen gibt es zwar schon im Netz, breite Resonanz haben die meisten aber nicht gefunden. Hier zum Beispiel ein Bildschirmfoto der inzwischen deaktivierten „Second Life“-Filiale der Staatlichen Kunstsammlungen Dresden. Abb.: BSF / Digital Classics Online

Was in einem Metaversum schieflaufen kann, zeigte vor zwei Dekaden schon „Second Life“

Beispiele dafür, wie rasch virtuelle Welten scheitern, wenn das „Drumherum“ aus Software, Hardware, Immersion und Unterhaltungsfaktoren nicht im Einklang funktioniert, gibt es einige. Erinnert sei nur an „Second Life“, das angeblich zweite Leben in einer virtuellen Welt, das 2003 startete. Obgleich es das Wort damals noch nicht gab, war auch diese Computerwelt als Metaversum gedacht. Doch das hochgejubelte Projekt verödete rasch zu einem Zombie-Friedhof. Denn die 3D-Technik in der Prä-Cloud-Ära überforderte damals viele Rechner. Auch sahen sich die „Bewohner“ an der wenig überzeugenden sterilen Computergrafikwelt schnell satt. Zudem starrte man beim Besuch eben immer auf einen Bildschirm, statt in die Szenen eintauchen zu können, auch gab es bald kaum noch neue Anreize, dieses „Second Life“ überhaupt leben zu wollen.

Autor: Heiko Weckbrodt

Quellen: IDTechEx, Oiger-Archiv

Ihre Unterstützung für Oiger.de!

Ohne hinreichende Finanzierung ist unabhängiger Journalismus nach professionellen Maßstäben nicht dauerhaft möglich. Bitte unterstützen Sie daher unsere Arbeit! Wenn Sie helfen wollen, Oiger.de aufrecht zu erhalten, senden Sie Ihren Beitrag mit dem Betreff „freiwilliges Honorar“ via Paypal an:

Vielen Dank!

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.