Fog Computing, das Rechnen im Nebel, könnte der nächste große Trend werden. Abb.: Pixabay.com, NeuPaddy, CC0-Lizenz

Nach dem Cloud-Boom kommt das Fog-Computing

Dresden, 4. Februar 2019. Im Cloud-Markt zeichnen sich neue Trends ab – und die gehen hin zur lokalen Rechnerwolke („Edge Cloud“) und zum verteilten Rechnen („Fog Computing“). Vor allem das autonome und vernetzte Fahren, die Hochautomatisierung in den „Industrie 4.0“-Fabriken, aber auch neue Unterhaltungskonzepte für den Endverbraucher werden diese Paradigmenwechsel erzwingen, weil diese Anwendungen allesamt zeitkritisch sind. „Letztlich werden diese neuen Konzepte aber überall wichtig sein“, in allen Szenarien, die Computern rasche Entscheidungen abverlangen, ist Professor Frank H. P. Fitzek überzeugt.

Ausfallsicherheit, Miniaturisierung, Datensicherheit

An seinem Telekom-Lehrstuhl für Kommunikationsnetzwerke an der TU Dresden verknüpfen er und seine Mitstreiter bereits seit geraumer Zeit die Glieder, die für diese neue Wertschöpfungskette gebraucht werden: Dazu gehören innovative Software-Konzepte, mehr Ausfallsicherheit, Supercomputer im Winzigformat und dergleichen mehr.

„Cloud Computing hat sich in aller Breite durchgesetzt“

Um dies einzuordnen, sollte man sich ins Gedächtnis rufen, wie sehr die Cloud unsere Wirtschaft und Gesellschaft umgeformt hat: Sie hat Geschäftsprozesse und Kostenstrukturen in den Unternehmen verändert, neue Geschäftsmodelle eröffnet und das kollaborative Arbeiten revolutioniert. Und Cloud-Computing hat Sprachassistentinnen wie Siri und Alexa oder Highend-Spiele auf Smartphones überhaupt erst möglich gemacht. Laut einer Erhebung von Bitkom und KPMG vom Sommer 2018 nutzen mittlerweile zwei Drittel aller deutschen Unternehmen Cloud-Computing. „Ob Kleinstbetrieb oder Großkonzern – Cloud Computing hat sich in aller Breite durchgesetzt“, schätzt KPMG-Technologiexperte Peter Heidkamp ein.

Risiken der Cloud

Doch je mehr Daten und Dienste über die Rechnerwolke abgewickelt werden, umso mehr Probleme werden offenbar: Wie sicher gegen Spähangriffe sind unsere Daten, wenn sich die Cloud physisch über nur ein paar Rechenzentren in den USA erstreckt? Wird der Breitband-Ausbau in Deutschland mit den zu versendenden Cloud-Daten mithalten, wenn das Internet der Dinge (IoT) richtig Fahrt aufnimmt?

Signale brauchen zu lange über den großen Teich

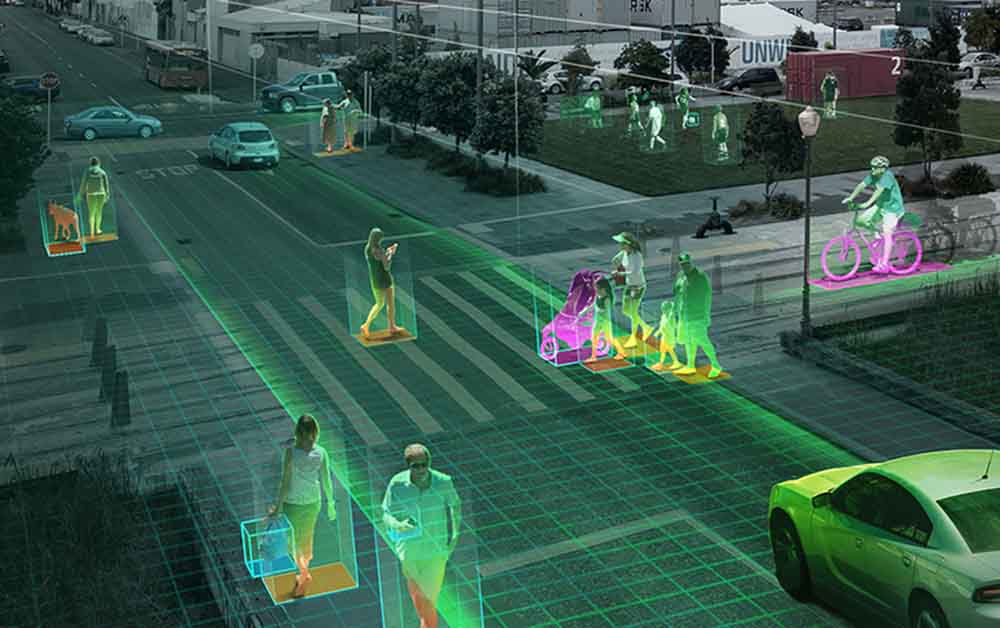

Neben den Transferraten rückt dann zudem ein ganz anderes Problem in den Vordergrund: Wenn sich ein autonom fahrendes Auto im sich rasch verändernden Großstadtverkehr mit all seinen Sensoren zu orientieren versucht, würde es viel zu lange dauern, um die Radar-, Kamera-, Lidar- und anderen Daten über heutige Clouds zu verarbeiten – schon allein, weil das Signaltempo auf die Lichtgeschwindigkeit begrenzt ist. „Da sprechen wir über Latenzzeiten von 30 bis 100 Millisekunden, wenn sie das über einen Amazon-Server in den USA abwickeln wollen“, warnt Fitzek. Derart lahme Reaktionszeiten können im Straßenverkehr tödliche Folgen haben. „Da kann schon längst ein Radfahrer auf die Straße gefahren sein.“

Edge Cloud: Die Rechnerwolke an der Straßenecke

Um dieses Latenzproblem zu umschiffen, haben Ingenieure und Forscher mehrere Konzepte entwickelt. Dazu gehört die „Edge Cloud“ bei der ein Großteil der Datenverarbeitung in einer nahen Rechnerwolke abgewickelt wird. Dies setzt allerdings voraus, dass winzige Rechenzentren beziehungsweise Supercomputer omnipräsent werden – in Straßenlaternen, Routern, in Autos und Mobilfunk-Stationen.

Prof. Frank Fitzek leitet den Telekom-Stiftungslehrstuhl für Kommunikationsnetze an der TU Dresden. Hier ist er im Show-Raum des 5G-Labs zu sehen. Foto: Heiko Weckbrodt

HAEC: 100 Millionen Rechenkerne

Eine mögliche Hardware-Lösung dafür entwickelt der Fitzek-Lehrstuhl im Zuge des Projektes „Highly Adaptive Energy-Efficient Computing” (HAEC). Derzeit arbeitet das Projektteam mit selbstentworfenen Rechnern mit 1000 Kernen. Letztlich sollen dabei Supercomputer mit 100 Millionen Rechnerkernen herauskommen, kaum größer als ein ungarischer Rubik-Würfel. Dahinter stecke ein ähnliches Konzept wie beim menschlichen Gehirn, das die meiste Zeit des Tages so gut wie nichts tue, um Energie zu sparen, erklärt Professor Fitzek. Genauso soll auch ein HAEC-Würfel, der beispielsweise mit einem Auto gekoppelt ist, nur dann alle seine Kerne hochfahren, wenn zum Beispiel ein Kind auf die Straße rennt. In der anderen Zeit würde er im Energiesparmodus arbeiten. Um Hitzeprobleme zu vermeiden, soll der HAEC imstande sein, Rechnenaufgaben zwischen seinen Kernen hin- und herzuschieben, damit kein Areal zu heiß wird.

SDN: Der Rechner abstrahiert sich

Außerdem arbeiten die Forscher mit Konzepten wie Software-defined Networking (SDN), bei dem Computerkomponenten abstrahiert und physisch getrennt werden. Das ist wichtig, um die Ausfallsicherheit und die Mobilität von Edge-Cloud-Systemen zu verbessern. Denn wenn zum Beispiel ein Auto von einer Cloud-Zelle zur nächsten wechselt, muss der Systemzustand immer der gleiche bleiben, was heißt: In der „Edge Cloud“ muss es möglich sein, ganze Systeme sehr schnell von einem Ort zum nächsten zu übertragen. Solche Migrationsfähigkeiten haben die TU-Forscher erst jüngst auf der IFA mit einem Spiel demonstriert: Der virtuelle Spielecomputer umfasste rund vier Gigabyte und wurde immer wieder übertragen – nach nur einer Millisekunde war das System wieder erreichbar.

Fog Computing: Das Rechenzentrum verteilt sich wie ein Aerosol

Noch ausfallsicherer wird Edge-Clouds aber erst durch die nächste Stufe: das „Fog Computing“ – in Anlehnung zur „Rechnerwolke“ der Clouds ist das gewissermaßen ein noch feiner verteilter „Nebel“ („Fog“) aus Computerkapazitäten. Durch mathematische Verfahren werden dabei gewissermaßen ganze Rechenzentren abstrahiert, in kleine virtuelle Tröpfen aufgelöst, die sich dann wie ein Aerosol über unzählige Edge-Cloud-Rechner und klassische Cloud-Rechenzentren verteilen. Fällt ein Tröpfchen aus, wird es in der nächsten Einheit nachgebildet, gewissermaßen wiedergeboren. Dies setzt allerdings voraus, dass Rechner-Kerne wirklich allerorten verbaut werden – bis hin zum Speedport im Wohnzimmer. „Dann würden wir uns ganz davon lösen können, für neue Funktionen neue Hardware installieren zu müssen“, sagt Prof. Fitzek. „Wir würden das einfach anfordern – und die Cloud implementiert das vor Ort.“

„Die Geschäftsperspektiven für Deutschland sind enorm“

Interessante Chancen sieht Prof. Uwe Aßmann von der Informatikfakultät, wenn die Wirtschaft das Fog-Computing mit deutschen Stärken in der Sensorik und Robotik kombiniert: „Die Geschäftsperspektiven für Deutschland sind enorm“, meint er. „Von den Sensormärkten aus können deutsche Unternehmen versuchen, in die zukünftigen Cloud-Märkte vorzudringen.“

Autor: Heiko Weckbrodt

Ihre Unterstützung für Oiger.de!

Ohne hinreichende Finanzierung ist unabhängiger Journalismus nach professionellen Maßstäben nicht dauerhaft möglich. Bitte unterstützen Sie daher unsere Arbeit! Wenn Sie helfen wollen, Oiger.de aufrecht zu erhalten, senden Sie Ihren Beitrag mit dem Betreff „freiwilliges Honorar“ via Paypal an:

Vielen Dank!

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.